🌐 Starten mit OpenAI-kompatiblen Servern

Übersicht

Open WebUI ist nicht nur für OpenAI/Ollama/Llama.cpp gedacht – Sie können jeden Server verbinden, der die OpenAI-kompatible API implementiert, sei er lokal oder remote. Dies ist perfekt, wenn Sie verschiedene Sprachmodelle ausführen möchten oder bereits ein bevorzugtes Backend oder Ökosystem haben. Diese Anleitung zeigt Ihnen, wie Sie:

- Einen OpenAI-kompatiblen Server einrichten (mit einigen beliebten Optionen)

- Diesen mit Open WebUI verbinden

- Sofort mit dem Chatten beginnen

Schritt 1: Einen OpenAI-kompatiblen Server auswählen

Es gibt viele Server und Tools, die eine OpenAI-kompatible API bereitstellen. Hier sind einige der beliebtesten:

- Llama.cpp: Extrem effizient, läuft auf CPU und GPU

- Ollama: Super benutzerfreundlich und plattformübergreifend

- LM Studio: Umfangreiche Desktop-App für Windows/Mac/Linux

- Lemonade: Schnelles ONNX-basiertes Backend mit NPU/iGPU-Beschleunigung

Wählen Sie, was am besten zu Ihrem Workflow passt!

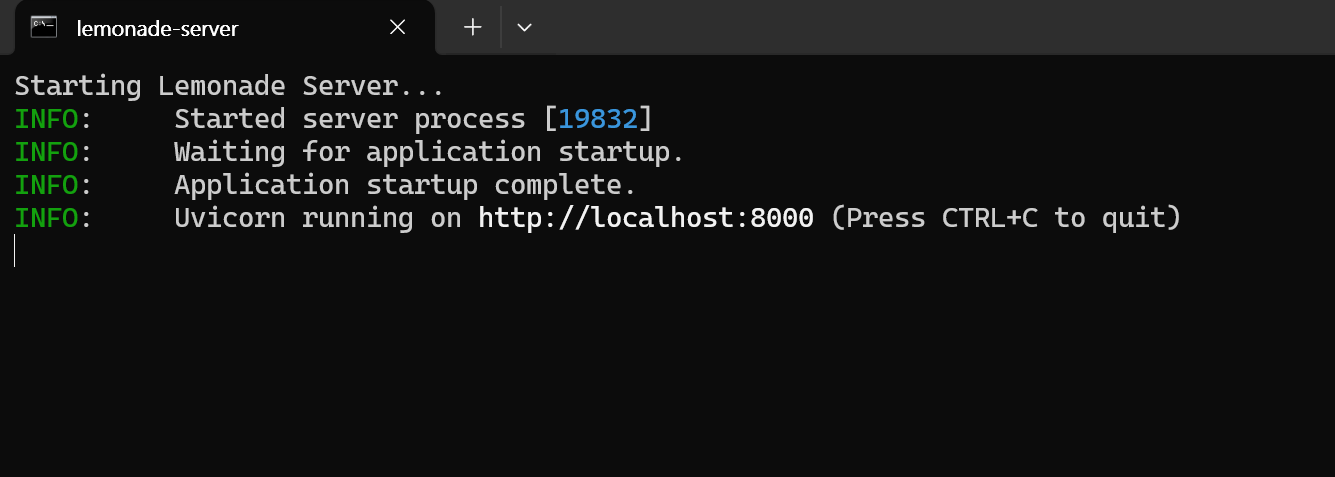

🍋 Mit Lemonade starten

Lemonade ist ein Plug-and-Play ONNX-basierter, OpenAI-kompatibler Server. Hier ist, wie Sie ihn unter Windows ausprobieren können:

-

Führen Sie

Lemonade_Server_Installer.exeaus -

Installieren und laden Sie ein Modell mit dem Lemonade-Installer herunter

-

Sobald er läuft, wird Ihr API-Endpunkt lauten:

https://:8000/api/v0

Weitere Details finden Sie in deren Dokumentation.

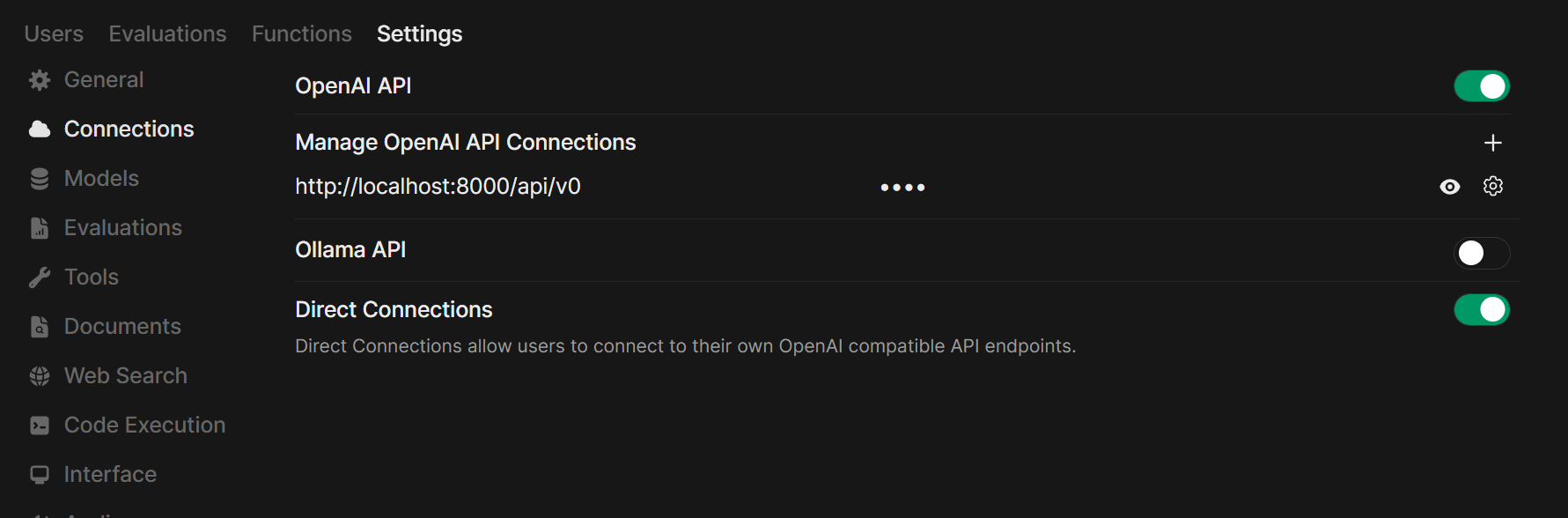

Schritt 2: Ihren Server mit Open WebUI verbinden

-

Öffnen Sie Open WebUI in Ihrem Browser.

-

Gehen Sie zu ⚙️ Admin-Einstellungen → Verbindungen → OpenAI-Verbindungen.

-

Klicken Sie auf ➕ Verbindung hinzufügen.

- URL: Verwenden Sie den API-Endpunkt Ihres Servers (z. B.

https://:11434/v1für Ollama oder die Adresse Ihres eigenen Llama.cpp-Servers). - API-Schlüssel: Leer lassen, es sei denn, er ist erforderlich.

- URL: Verwenden Sie den API-Endpunkt Ihres Servers (z. B.

-

Klicken Sie auf Speichern.

Tipp: Wenn Sie Open WebUI in Docker ausführen und Ihr Modellserver auf Ihrem Host-Computer läuft, verwenden Sie http://host.docker.internal:<ihr-port>/v1.

Für Lemonade: Verwenden Sie beim Hinzufügen von Lemonade https://:8000/api/v0 als URL.

Schritt 3: Mit dem Chatten beginnen!

Wählen Sie das Modell Ihres verbundenen Servers im Chat-Menü aus und legen Sie los!

Das war's! Egal, ob Sie Llama.cpp, Ollama, LM Studio oder Lemonade wählen, Sie können ganz einfach experimentieren und mehrere Modellserver verwalten – alles in Open WebUI.

🚀 Viel Spaß beim Aufbau Ihres perfekten lokalen KI-Setups!